關於應該圍繞生成人工智慧設定的參數及其使用方式的持續爭論中,Meta 最近與 史丹佛大學協商民主實驗室 進行一次 生成人工智慧社群論壇為了收集實際用戶對負責任的人工智慧開發的期望和擔憂的回饋。

該論壇收錄了來自超過 來自巴西、德國、西班牙和美國的 1500 人參加,重點討論了人們在人工智慧開發中看到的關鍵問題和挑戰。

關於公眾對人工智慧及其好處的看法,有一些有趣的註釋。

正如 Meta 所強調的,頂線結果顯示:

- 各國大多數參與者認為人工智慧產生了正面影響

- 大多數人認為,只要人們了解情況,人工智慧聊天機器人就應該能夠利用過去的對話來改善回應

- 大多數參與者認為,只要人們了解情況,人工智慧聊天機器人就可以像人類一樣。

雖然具體細節很有趣。

正如您在此範例中所看到的,最積極和最消極反應的陳述因地區而異。 在整個過程中,許多參與者確實改變了對這些要素的看法,但考慮目前人們在哪些方面看到人工智慧的好處和風險是很有趣的。

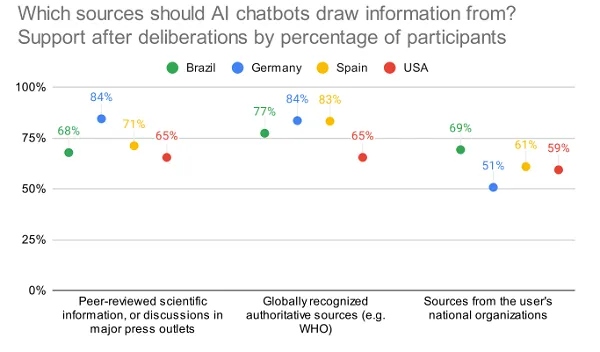

該報告還研究了消費者對人工智慧揭露的態度,以及人工智慧工具應從何處獲取資訊:

有趣的是,美國對這些來源的認可度相對較低

還有關於人們是否認為用戶應該能夠與人工智慧聊天機器人建立浪漫關係的見解。

有點奇怪,但這是一個合乎邏輯的進展,並且需要考慮。

研究中沒有特別強調的人工智慧開發的另一個有趣的考慮因素是每個提供者在其人工智慧工具中實施的控制和權重。

谷歌最近被迫為其Gemini 系統產生的誤導性和不具代表性的結果道歉,該系統過於傾向於多樣化的代表性,而Meta 的Llama 模型也因根據某些提示產生更乾淨、政治正確的描述而受到批評。

這樣的例子凸顯了模型本身對輸出的影響,這是人工智慧開發的另一個關鍵問題。 企業應該對這些工具擁有這樣的控制權嗎? 是否需要更廣泛的監管來確保每種工具的平等代表性和平衡?

大多數問題都無法回答,因為我們尚未完全了解此類工具的範圍,以及它們如何影響更廣泛的反應。 但越來越明顯的是,我們確實需要建立一些通用的防護欄,以保護使用者免受錯誤訊息和誤導反應的影響。

因此,這是一場有趣的辯論,值得考慮的是結果對更廣泛的人工智慧發展意味著什麼。

您可以在此處閱讀完整的論壇報告。