當 Reddit 上有人聲稱 Mueller 的部落格受到有用內容系統的影響並隨後被取消索引時,Google 約翰·穆勒 (John Mueller) 個人部落格的 robots.txt 檔案成為人們關注的焦點。 事實證明並沒有那麼戲劇化,但仍然有點奇怪。

SEO Reddit 子版塊帖子

約翰·穆勒 (John Mueller) robots.txt 傳奇始於一位 Reddit 用戶發文稱約翰·穆勒 (John Mueller) 的網站已取消索引,並稱該網站與谷歌的演算法相衝突。 但諷刺的是,情況永遠不會是這樣,因為只花了幾秒鐘加載網站的 robots.txt 就發現發生了奇怪的事情。

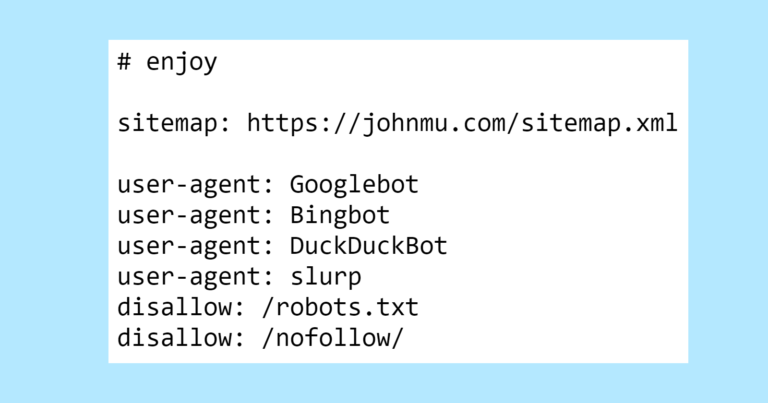

這是 Mueller 的 robots.txt 的頂部,其中有一個帶有評論的復活節彩蛋,供那些看一下的人使用。

您每天都不會看到的第一個內容是 robots.txt 中的禁令。 誰使用他們的 robots.txt 來告訴 Google 不要抓取他們的 robots.txt?

現在我們知道了。

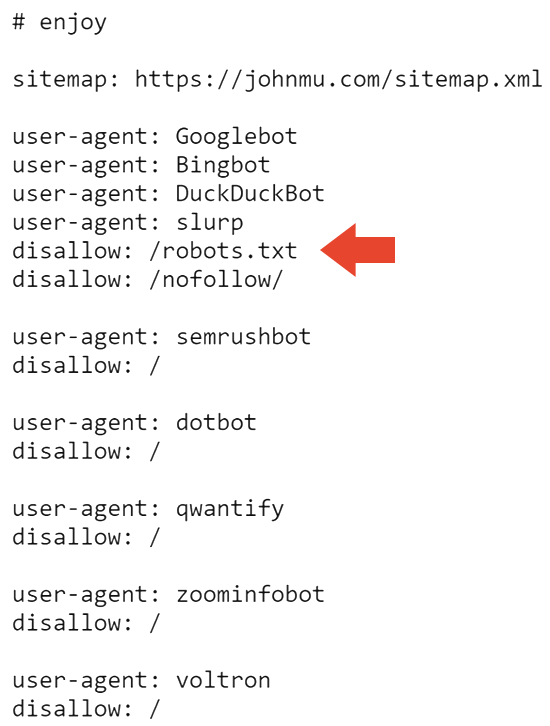

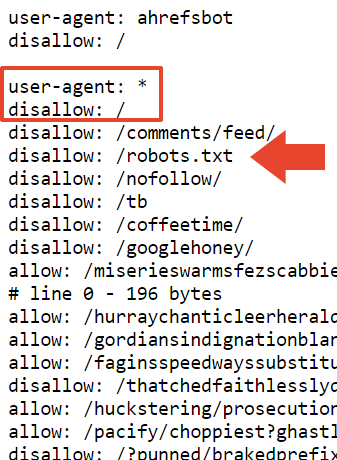

robots.txt 檔案的下一部分會阻止所有搜尋引擎抓取網站和 robots.txt。

這可能解釋了為什麼該網站在谷歌中被取消索引。 但它並沒有解釋為什麼它仍然被 Bing 索引。

我問過,網頁開發人員和 SEO(LinkedIn 個人資料)Adam Humphreys 表示,Bingbot 可能沒有出現在 Mueller 的網站上,因為它是一個基本上不活躍的網站。

Adam 給我發了一封訊息,表達了他的想法:

「用戶代理: *

禁止:/toppsy/

禁止:/crets/

禁止:/hidden/file.html在這些範例中,將找不到資料夾和該資料夾中的檔案。

意思是您不允許 Bing 忽略但 Google 聽到的 robots 檔案。

Bing 會忽略錯誤實施的機器人,因為許多人不知道如何做到這一點。 」

Adam 也表示,也許 Bing 完全忽略了 robots.txt 檔案。

他是這樣向我解釋的:

「是,或者選擇忽略不讀取指令檔的指令。

Bing 中實作不當的機器人提示可能會被忽略。 這對他們來說是最合乎邏輯的答案。 這是一個提示文件。”

Robots.txt 上次更新時間是 2023 年 7 月至 11 月,因此 Bingbot 可能沒有看到最新的 robots.txt。 這是有道理的,因為微軟的 IndexNow 網路爬行系統優先考慮高效爬行。

Mueller 的 robots.txt 封鎖的目錄之一是 /nofollow/(這是一個奇怪的資料夾名稱)。

除了一些網站導航和“重定向器”一詞之外,該頁面基本上沒有任何內容。

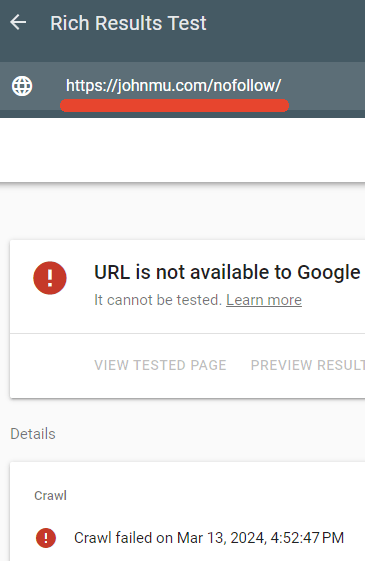

我測試了 robots.txt 是否阻止了該頁面,確實如此。

Google 的豐富結果檢查器無法抓取網頁 /nofollow/。

約翰·穆勒的解釋

穆勒似乎很高興他的 robots.txt 受到如此多的關注,並在 LinkedIn 上發布了對正在發生的事情的解釋。

他寫了:

「但是文件呢? 為什麼您的網站被取消索引?

有人建議這可能是因為 Google+ 連結。 有可能。 回到 robots.txt…沒關係; 我的意思是,這就是我想要的,追蹤器可以處理它。 或者如果他們遵循 RFC9309,他們應該能夠做到。”

然後他說 robots.txt nofollow 只是為了防止它被索引為 HTML 檔案。

解釋:

“”disallow: /robots.txt” – 這會讓機器人繞圈嗎?這會取消您網站的索引嗎?不會。

我的 robots.txt 檔案有很多內容,如果不為其內容建立索引,它會更乾淨。 這只會阻止 robots.txt 檔案因索引目的而被爬網。

我還可以使用帶有 noindex 的 x-robots-tag HTTP 標頭,但這樣我也可以將它放在 robots.txt 文件中。”

穆勒對於文件大小也有這樣的說法:

「這個大小來自於我和我的團隊使用過的各種 robots.txt 測試工具的測試結果。RFC 規定爬蟲應該解析至少 500 KB(有些像第一個人解釋它是什麼類型的零食。)必須停在某個地方,你可以使頁面無限長(我和很多人都這樣做,有些人甚至是故意的)。在實踐中,會發生的情況是,檢查robots.txt 檔案的系統(解析器)將產生一個切到某處。”

他還表示,他在本節頂部添加了免責聲明,希望將其視為“一般免責聲明”,但我不確定他在談論哪項免責聲明。 您的 robots.txt 檔案正好有 22,433 個禁令。

他寫了:

“我在本節的頂部添加了一個“disallow: /”,所以我希望它能作為一般禁令被採納。解析器可能會在一個尷尬的地方被切斷,比如包含“allow : /cheeseisbest”的行”並在“/”處停止,這將使解析器死鎖(而且,有趣的是!允許規則)。如果您有“允許:/”和“不允許:/”,它將覆蓋。但是,這,似乎不太可能。”

就是這樣。 約翰·穆勒奇怪的 robots.txt。

Robots.txt 可見:

https://johnmu.com/robots.txt