隨著生成式人工智慧的使用不斷增加,Meta 正在努力圍繞其應用程式中的人工智慧揭露制定新規則,這不僅會讓用戶有更多責任在其內容中聲明人工智慧的使用,而且在理想情況下還可以實施新系統透過技術手段檢測人工智慧的使用情況。

這並不總是可能的,因為大多數數位水印選項很容易被破壞。 但理想情況下,Meta 希望透過與其他提供者合作來製定有關人工智慧檢測的新行業標準,以提高人工智慧透明度,並建立新的工作規則來突出此類插播內容。

正如 Meta 所解釋的:

“我們正在建立業界領先的工具,可以大規模識別隱形標記 – 具體來說, C2PA 中的「AI 產生」訊息 和 IPTC 技術標準 – 因此我們可以標記來自 Google、OpenAI、Microsoft、Adobe、Midjourney 和 Shutterstock 的圖像,因為他們正在實施向其工具創建的圖像添加元數據的計劃。”

這些技術檢測措施將理想地使 Meta 和其他平台能夠在生成人工智慧創建的內容出現的任何地方對其進行標記,以便所有用戶更好地了解合成內容。

這將有助於減少人工智慧導致的錯誤訊息的傳播,儘管當前人工智慧領域的這種能力存在限制。

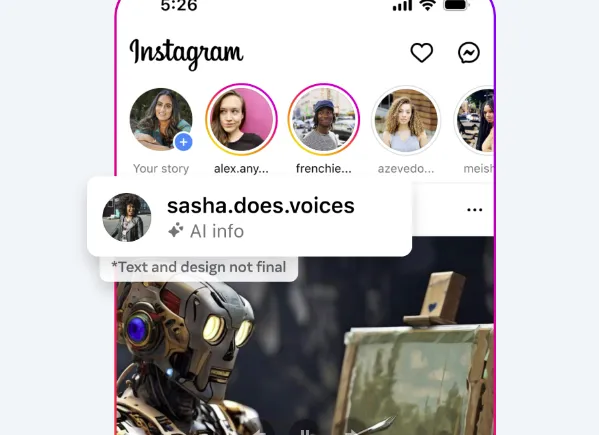

“雖然公司開始將訊號納入其影像產生器中,但他們還沒有開始將它們納入以相同規模生成音訊和視訊的人工智慧工具中,因此我們尚無法偵測到這些訊號並標記其他公司的內容。 雖然業界正在努力實現這項功能,但我們正在添加一項功能,供人們在共享人工智慧生成的視訊或音訊時披露,以便我們可以為其添加標籤。 我們將要求人們在發布帶有數位創建或更改的逼真視頻或逼真音頻的有機內容時使用此披露和標籤工具,如果他們不這樣做,我們可能會施加處罰。”

這是更廣泛的人工智慧開發中的關鍵問題,尤其是谷歌已經多次發出警報。

雖然像 ChatGPT 這樣的新型生成式人工智慧工具的開發是該技術的重大飛躍,但谷歌認為,由於存在濫用造成傷害的風險,我們在向公眾發布此類工具時應該採取更加謹慎的態度。

我們已經看到生成式人工智慧影像引起了混亂, 來自更無辜的例子,例如 穿著羽絨外套的教皇更嚴重的,例如 五角大廈外假爆炸的後果。 沒有標籤和未經證實,很難分辨什麼是真的,什麼是假的,雖然更廣泛的互聯網已經相當快地揭穿了這些例子,但你可以看到,在某些情況下,比如選舉,雙方的激勵如何能夠使這一點更有問題。

影像標籤將改善這一點,Meta 再次表示,它正在開發更難以迴避的數位浮水印選項。 但正如它也指出的那樣,音訊和視訊人工智慧目前還無法被檢測到。

我們已經看到政治運動中使用了這種方法:

這就是為什麼一些人工智慧專家一再提出擔憂,當它們交到公眾手中後,我們現在回想起來,實施保障措施似乎確實有些問題。

當然,正如Google所建議的那樣,我們應該先開發這些工具和系統,然後再考慮部署。

但與所有技術變革一樣,大多數監管都會事後回顧。 事實上,美國政府已經開始召集人工智慧監管工作小組,這已經啟動了改善管理的最終框架。

這需要數年時間,而且隨著 2024 年世界各地將舉行一系列重要選舉,這種情況的先有雞還是先有蛋的情況似乎確實是混亂的。

但我們不能阻止進步,因為如果美國放慢腳步,中國也不會,西方國家最終可能會落後。 因此,我們需要繼續推進,這將在即將到來的選舉期間打開各種安全漏洞。

可以打賭,人工智慧將在美國總統競選中發揮作用。

也許,在未來,Meta 的努力,與其他科技巨頭和立法者的結合,將促進更多的保障措施,現在在這方面開展關鍵工作是件好事。

但同樣令人擔憂的是,我們正試圖重新封閉一個早已被釋放的精靈。