Meta 宣布了一項新舉措,旨在圍繞開發大型語言模型(LLM) 和生成式AI 工具時的網絡安全考慮因素建立商定的參數,它希望這一舉措能夠被更廣泛的行業採用,作為促進提高AI 安全性的關鍵一步。

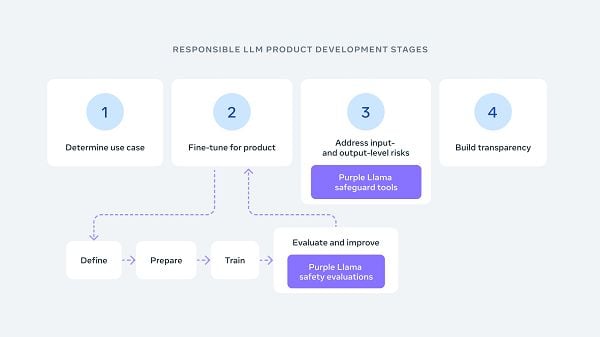

該項目名為“Purple Llama”,基於其自己的 Llama LLM,旨在“匯集工具和評估,幫助社區負責任地建立開放式生成人工智慧模型”

據 Meta 稱,Purple Llama 計畫旨在為法學碩士建立第一套全行業範圍的網路安全評估。

根據元:

「這些基準是基於行業指南和標準(例如 CWE 和 MITRE ATT&CK),並與我們的安全主題專家合作建構。 透過這個初始版本,我們的目標是提供工具,幫助解決白宮關於開發負責任的人工智慧的承諾中概述的一系列風險。”

白宮最近的人工智慧安全指令敦促開發人員建立標準和測試,以確保人工智慧系統的安全,保護用戶免受基於人工智慧的操縱,以及其他可以理想地阻止人工智慧系統佔領世界的考慮因素。

以下是 Meta 的 Purple Llama 專案的驅動參數,該專案最初將包括兩個關鍵要素:

- CyberSec Eval – 業界認可的法學碩士網路安全評估基準

- Llama Guard – 一個用於防止具有潛在風險的 AI 輸出的框架。

“我們相信這些工具將減少法學碩士提出不安全的人工智慧產生程式碼的頻率,並減少它們對網路對手的幫助。 我們的初步結果表明,法學碩士存在重大的網路安全風險,無論是推薦不安全的程式碼還是遵守惡意請求。”

Purple Llama 將與 Meta 協助領導的新成立的人工智慧聯盟的成員合作,該聯盟的創始合作夥伴還包括微軟、AWS、Nvidia 和Google雲端。

那麼「紫色」與它有什麼關係呢? 我可以解釋一下,但這太書呆子了,一旦你讀到它,你就會後悔讓這些知識佔據了你的頭腦。

隨著生成式人工智慧模型的快速發展,人工智慧安全正迅速成為一個關鍵的考慮因素,專家警告說,建構可能為自己「思考」的系統存在危險。

長期以來,人們一直擔心科幻悲劇和人工智慧的厄運,有一天,我們將創造出能夠超越人類大腦思考的機器,有效地使人類過時,並在地球上建立一個新的主導物種。

我們離這成為現實還有很長的路要走,但隨著人工智慧工具的進步,這些擔憂也在加劇,如果我們不完全了解這些過程可能產生的輸出程度,人工智慧開發確實可能會出現重大問題。

與此相反的是,即使美國開發商放慢了進度,也不代表其他市場的研究人員會遵循相同的規則。 如果西方政府阻礙進展,這也可能成為一種生存威脅,因為潛在的軍事競爭對手會建造更先進的人工智慧系統。

那麼,答案似乎是在安全措施和規則方面加強行業合作,這將確保所有相關風險都得到評估和考慮。

Meta 的 Purple Llama 計畫是這條道路上的另一步。

您可以在此處閱讀有關紫色駱駝倡議的更多資訊。